هوش مصنوعی، نیازمند نگاه پویا است

نگاه انتقادی یا اثباتی ما، دلیل اصلی شکست ماستدومین نشست از سلسله نشستهای «فرهنگ عمومی، اخلاق و هوش مصنوعی» سهشنبه ۱۷ آبان ۱۴۰۱ با حضور محمدرضا قاسمی (رئیس مرکز نوآوری حکمرانی هوشمند دانشگاه علم و صنعت)، ایمان ظهوریان (سرپرست دیدهبان هوش مصنوعی پارت)، حامد اجاقی (کارشناس دیدهبان هوش مصنوعی پارت) و فاطمه سلیمانی (کارشناسی دیدهبان هوش مصنوعی پارت) با دبیری محمد نصراوی (دانشجوی دکتری سیاستگذاری فرهنگی) در پژوهشگاه فرهنگ، هنر و ارتباطات برگزار شد.

در ابتدای این برنامه حامد اجاقی با طرح یک سوال مبنی بر اینکه چرا کشورهای پیشرفته نسبت به جوامع کمالگرا، سطح بالاتری از مقالات، اسناد و سیاستهای اخلاقی دارند، درباره تفاوت ماهیت نیاز به اسناد اخلاقی در کشورهای مختلف صحبت کرد و گفت: به نظر نمیرسد که کشورهای پیشرفته، دغدغههای بالاتری در زمینه کمالگرایی انسانی داشته باشند. ذات لیبرالگرایی این کشورها کمک میکند به کمک تنظیمات اخلاقی، آثار نامطلوب احتمالی را جبران کنند. یک تفاوت اساسی در توسعه فناوری در کشورهای پیشرو و کشور ما وجود دارد. در کشورهای پیشرو، فناوری و سطح بهرهوری از ان است که پیشتازی میکند و بعد، حکمرانان و بقیه عوامل، مجبور میشوند آثار و پیامدهای احتمالی آن را جبران کنند که این با رویکرد کشورهایی مثل کشور ما، کمی تفاوت دارد. ما چندان در زمینه فناوری هوش مصنوعی پیش نرفتهایم و هنوز مثل کشورهای پیشرو با آثار و عواقب نادرست آن درست به گریبان نشدهایم اما به ملاحظات اخلاقی آن توجه میکنیم. در این میان باید ببینیم حکمرانان، شرکتها و محققان، چه نگاه و تعریفی نسبت به اسناد اخلاقی دارند؟ در نگاه سنتی، اسناد اخلاقی، به عنوان چیزی تلقی میشوند که اهداف آنها، متوقف کردن یا ممنوعیت فعالیتها، ممانعت از تحقیقات ارزشمند و تلاشهای اقتصادی است. درحالی که هدف اخلاق نباید خفهکردن فعالیت باشد بلکه برعکس، باید دامنه عمل را گسترش دهد، نقاط کور را کشف کند، خودمختاری و آزادی را ارتقا دهد و مسئولیت شخصی را پرورش دهد. در اسناد اخلاقی هوش مصنوعی چین هم با وجود اولویتدار بودن توجه به مکتب فکری و ایدئولوژی، هدف نهایی از تنظیم این اسناد، انتفاع انسانها از هوش مصنوعی عنوان شده است تا به توسعه هرچه بیشتر این فناوری کمک کنند. درحالی که کشورهای غربی سیاست فردگرایی را دنبال میکنند، کشور چین ایدئولوژیهای مبتنی بر جمعگرایی را پی میگیرد. ما نباید هیچ کدام از این دو سبک را قضاوت درست یا غلط کنیم چراکه هرکدام، نظام فکری جداگانهای دارند. درخصوص کشور خود هم باید بدانیم که اسناد اخلاقی کنترلکننده هوش مصنوعی را نباید بهعنوان یک پدیده ایستای یکبار برای همیشه در نظر بگیریم. این فناوری ماهیت پویا دارد، ما هم باید به آن نگاه پویا داشته باشیم. در غیر اینصورت دچار سردرگمی در انواع چالشهای اخلاقی خواهیم شد. با گسترش و پیشرفت شرایط هوش مصنوعی در کشور، دغدغهها و نیازمندیها در هر مرحله تغییر خواهد کرد. به همین دلیل نیازمند نگرش پویا هستیم و لازم است براساس اقتضائات فعلی به تنظیم توصیهنامهها بپردازیم. این چالشها ممکن است در خیلی از کشورها وجود داشته باشد اما در کشوری مثل کشور ما که حساسیتهای اخلاقی بیشتری دارد، این ملاحظات بیشتر میتواند در مسیر گسترش هوش مصنوعی مانع ایجاد کند.

او با بیان اینکه باید اخلاق هوش مصنوعی را در هماهنگی و ذیل سیاست نوآوری هوش مصنوعی دید نه مستقل از آن، این الزام را مشروط به جانمایی اخلاق هوش مصنوعی ذیل مشروعیتبخشی دانست و عنوان کرد: مشروعیتبخشی به معنای متقاعدکردن آحاد جامعه، مخاطبان و ذینفعان این فناوری است تا مقاومتها و محدودیتهای پیشروی این فناوری کاهش یابد. درواقع مشروعیتبخشی تلاش میکند استفاده از این فناوری و محصولات آن را مانعزدایی کند.

کارشناس دیدهبان هوش مصنوعی پارت در پایان با بیان اینکه به هنگام صحبت از توسعه هوش مصنوعی باید دو بخش را از هم تفکیک کنیم، خاطرنشان کرد: ما در زمینه پیشرفت هوش مصنوعی باید ببینیم به دنبال ساحت تسلط بر علم، دانش و توانمندیهای این فناوری هستیم یا به دنبال ساحت بهرهوری از این فناوری. تسلط بر ساحت اول میتواند خوب باشد و برای هر کشوری مایه مباهات باشد اما در یک فناوری مانند هوش مصنوعی، بیش از آنکه تسلط بر علم دارای اهمیت باشد، سطح بهرهوری از آن مهم است. اگر ما جهتگیری مناسبی در این خصوص نداشته باشیم، ممکن است در سالهای آینده صرفاً در زمینه دانشورزی در هوش مصنوعی به جایگاه مناسب برسیم نه در زمینه بهرهوری از آن. سطح توسعه این فناوری، به شدت به سطح بهرهوری از آن وابسته است.

محمدرضا قاسمی دومین سخنران این برنامه با طرح این سوال که «چطور میتوانیم در زمینه هوش مصنوعی پیش برویم که هم روند توسعه را طی کنیم و هم این توسعه، با زیستبوم فرهنگی ما سازگار باشد؟»، درباره نسبت بین حکمرانی اخلاقی و هوش مصنوعی اظهار داشت: در بررسی نسبت اخلاقی فضای حکمرانی هوش مصنوعی ابتدا باید برخی مسائل را روشن کنیم. ما در نسبتی که میخواهیم برقرار کنیم، ابتدا باید ببینیم الگوی این نسبت چیست. ما یک نقشه جامع علمی کشور داریم که طبیعتاً پیشرفت در حوزههای علم و فناوری باید مبتنی بر همین نقشه باشد. ما باید آنچه که از این سند برمیآید را در الزامات توسعه هوش مصنوعی ببینیم. البته از آنجایی که هوش مصنوعی یک فناوری تحولی و پیشران است و میتواند بسیاری از عرصههای زندگی ما را تحتالشعاع قرار دهد، طبیعتاً باید یک الگوی زیست ایرانی اسلامی را هم در این مدل توسعه و حکمرانی هوشمند ببینیم که چیزی جز بیانیه گام دوم انقلاب نیست. باید ببینیم در هوش مصنوعی میخواهیم صرفاً نگاه تکنیکال به مسأله داشته باشیم یا اینکه قرار است هوش مصنوعی را بهعنوان یک پارادایم حکمرانی ببینیم. اگر تلقی ما از هوش مصنوعی، بیشتر از یک فناوری است، طبیعتاً در آن مسأله باید ابعاد دیگر را هم ببینیم. مسأله اول ما در سند جامع علمی کشور، افزایش استقلال و اقتدار کشور در منطقه و سطح بینالمللی است. توجه به نقش هوش مصنوعی در حکمرانی آینده و داشتن نگاه آیندهنگرانه با هدف شناخت مسائل پیشرو، توجه به مسائل اخلاقی و اندیشیدن تمهیدات لازم، اخلاقمحوری، درنظر داشتن ارزشها و هنجارهای بومی در تولید محصولات بومی و ارئه خدمات، گسترش عدالت، صیانت از حریم خصوصی افراد و صیانت از دادههای ملی، حفظ کرامت انسانی و معیشت مشاغل منسوخشده حاصل از گسترش کاربردهای هوش مصنوعی، از دیگر مواردی است که با توجه به سند جامع علمی کشور، در حوزه هوش مصنوعی هم باید دیده شود.

او در ادامه به الزامات توسعه هوش مصنوعی از منظر حکمرانی اخلاقی اشاره و تصریح کرد: باتوجه به سند جامع علمی کشور، توسعه اخلاقی هوش مصنوعی الزاماتی دارد ازجمله اینکه باید شفافیت قوانین اخلاقی ایجاد کنیم و مسئولیتهای اخلاقی را در حکمرانی هوشمند ببینیم که تدوین استانداردهای اخلاقی فناوری و الزام شرکتهای حوزه هوش مصنوعی به تدوین اصول و چارچوبهای هنجاری روشن، ازجمله این اقدامات است. ترغیب مراکز کلیدی آگاه و همسو به حرکت فعالانه با استفاده هدفمند از هوش مصنوعی، حمایت از پژوهشهای عرصههای اخلاقی و حکمرانی هوش مصنوعی، تبدیل حاکمیت به الگویی مسئولانه در پذیرش و کاربست هوش مصنوعی، ارتقا فهم عمومی از مسأله هوش مصنوعی با برگزاری گردهماییها و تخصیص بودجههای آموزشی را هم میتوان بهعنوان الزامات دیگر توسعه هوش مصنوعی از منظر حکمرانی اخلاقی، برشمرد.

قاسمی در پایان با بیان اینکه برای رفع چالشهایمان، باید خود را در معرض پرسشهای بنیادین ارزششناختی و اخلاقی قرار دهیم، به طرح برخی از این سوالات پرداخت که پرسش از تهدیدها و چالشهای هوش مصنوعی برای ارزشهای انسانی، معنای اخلاق در هوش مصنوعی، رویکردهای موجود در اخلاقمندی هوش مصنوعی و ... ازجمله آنها بود.

در ادامه فاطمه سلیمانی با اشاره به موضوع رعایت اخلاق در صنایع مرتبط با هوش مصنوعی گفت: متأسفانه شرکتها با همان سرعت و فوریتی که در استفاده از هوش مصنوعی پیش میروند، با فوریت در افزایش تعهد در استفاده از آن مواجه نیستند. هرچند ممکن است توسعه هوش مصنوعی اخلاقی چندان خوشایند شرکتها نباشد، اما مسئولیت تمام سازمانها برای تضمین صحت دادهها از این حیث که بتوانند مسئولانه و بدون اغماض اخلاقیات را به کار گیرند، همواره مطرح است. بدون هوش مصنوعی اخلاقمدار، اعتماد مشتریان از بین میرود، تعصبات دامنه پیدا میکند و خطاهای دادهای ایجاد میشود که همه اینها برای کسبوکارها خطر ایجاد میکنند. همه ذینفعان انتظار دارند در قبال راهحلهای فناوری که ایجاد شده و برای ایجاد تأثیر مثبت بر جهان استفاده میشوند، مسئولیتپذیری هم وجود داشته باشد.

او «شفافیت» و «پاسخگویی» را دو مولفه اصلی اخلاقمداری در هوش مصنوعی دانست و افزود: شفافیت یک ساختار اخلاقی کلیدی است که با درک سیستمهای هوش مصنوعی مرتبط است. شفافیت به عنوان شفافیت سیستمهای هوش مصنوعی و دادهها و الگوریتمهای مورد استفاده، تعریف میشود. به عبارت دیگر، شفافیت، یک اصل اخلاقی استکه اجرای اخلاقی هوش مصنوعی را در مرحله اول ممکن میکند. پاسخگویی هم به تعیین شخص پاسخگو در قبال تصمیمات اتخاذشده توسط هوش مصنوعی اشاره دارد.

سلیمانی ضمن اشاره به تفاوت صنایع در نیاز به پذیرش اخلاق هوش مصنوعی، از مقوله «اعتماد به هوش مصنوعی» به عنوان راهکار چالشهای اخلاقی استفاده از هوش مصنوعی یاد کرد و گفت: تدوین استانداردهای اخلاقی با مقررات قابل اجرا بسیار پیچیده است و چالشهای استفاده اخلاقی از هوش مصنوعی در بین صنایع برابر نیست. به طور مثال، استفاده از هوش مصنوعی در صنعت سلامت، میدان مینی از مشکلات اخلاقی است. ۴ صنعت حملونقل خودران، خدمات مالی و بیمه، ژورنالیسم و اخبار جعلی و صنایع نظامی، نیاز به توجه بیشتر و ضرورت بیشتری نسبت به پیادهسازی اخلاقی هوش مصنوعی دارند. اساساً روابط انسانی براساس اعتماد هستند. زمانی که هوش مصنوعی وارد روابط انسانها شود، باید این اعتماد را در این فضا هم ایجاد کنیم. معمولاً احساس امنیت، با حس کنترل شدن در کاربران از بین میرود. اما زمانی که بتوانیم سیستمهایی داشته باشیم که این حس اعتماد برای کاربران به وجود بیاید، هراس از شفافیت کمتر خواهد شد و متقابلاً مسئولیتپذیری بیشتر و نهایتاً اخلاقیات، قابل وصولتر خواهند بود.

او با اشاره به استانداردهای بینالمللی و چگونگی تبدیل هنجارهای اخلاقی به استانداردها اضافه کرد: استانداردهای بینالمللی میتوانند دستورالعملهای مستقیم و دقیقی را برای توسعهدهندگان اضافه کنند و نشان دهند که چطور یک برنامه هوش مصنوعی میتواند بهصورت اخلاقی عمل کند و قابلیت همکاری، شفافیت و ایمنی داشته باشد. استانداردهای توسعهیافته توسط نهادهای بینالمللی مانند ISO، میتوانند از کنترل جهانی توسعه هوش مصنوعی پشتیبانی کنند و همزمان، یک سیستم حقوقی با پیکربندی مناسب اعمال کنند که اعتماد کاربران را به فناوریهای هوش مصنوعی افزایش دهند و از توسعه فناوری کاربردی هوش مصنوعی اخلاقی نیز، پشتیبانی کنند. نمونههایی از این استانداردهای فنی اخلاق هوش مصنوعی توسط سازمانهایی مثل ISO و IEC تدوین شده است.

ایمان ظهوریان سخنران چهارم این نشست از دریچه ارتباط هوش مصنوعی با فرهنگ به موضوع نگاه کرد و با بیان اینکه فناوری بیغرض نیست، هوشمصنوعی را بیش از سایر فناوریها دارای غرض و سوگیری دانست و گفت: فناوری بهخصوص هوش مصنوعی تأثیر شگرفی بر دو مقوله عدالت و آزادی دارد. چون به دنبال این است که به سطح توانمندیهای بشر برسد و یادگیری انسانی را در خود پیاده کند.

او بحث حریم خصوصی و تبعیضزدایی در هوش مصنوعی را انعکاسی از دو مقوله آزادی و برابری دانست و افزود: در بیش از ۳۰ سند جهانی مرتبط با هوش مصنوعی، مضامین متنوعی گنجانده شده که از بین آنها حریم خصوصی، انعکاسی از بحث آزادی اجتماعی در سطح فردی است و تبعیضزدایی در هوش مصنوعی، مقوله برابری و عدالت را برای ما تداعی میکند.

سرپرست دیدهبان هوش مصنوعی پارت درباره الزامات نگاه زیستبومی هوش مصنوعی، اظهار داشت: در مدل نگاه زیستبومی فناوری، هوش مصنوعی را دارای دو طرف عرضه و تقاضا میدانم. طرف عرضه بازیگرانی هستند که یا در رقابت و تعارض و یا در همکاری با یکدیگر هستند. طرف تقاضا هم جایی است که فرهنگ عمومی در آن نقشآفرینی میکند. در این اکوسیستم، ابزارهای سیاستگذاری فناوری که از طرف حاکمیت مورد استفاده قرار میگیرند، در طرف عرضه تأثیرگذاری میکنند. اگر ما میخواهیم عدالت و آزادی در محصولات مربوط به هوش مصنوعی در هر دو طرف عرضه و تقاضا پیادهسازی شود، ابتدا باید این مفاهیم، خود را با یک تعریف مشخصی در حوزه توسعه فناوری نشان دهند. مثلاً حکمران باید این عدالت را طوری ببیند که برایش فرقی نکند کدام شرکت و از چه استانی دریافتکننده تمهیدات است. و یا در حوزه آزادی که نگرانی بخش خصوصی است، این مسأله مهم است که حکمرانان با اسناد و تعیین استانداردهای پیچیده، سد راه توسعه فناوری آنها نشوند.

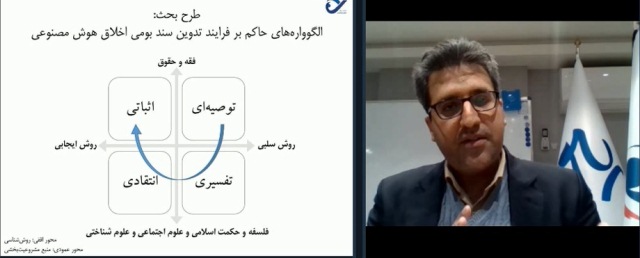

ظهوریان درباره چالش اصلی چیستی عدالت و آزادی در زیستبوم فرهنگی ما هم به ایراد سخن پرداخت و تصریح کرد: توجه به الگووراهها و پارادایمهای حاکم بر نوشتن اسناد بالادستی و نقشههای راه بهخصوص در هوش مصنوعی، گاهی اوقات مغفول مانده است. مطالعات نشان میدهند در این حوزه، به سمت یک پارادایم اثباتی حرکت کردهایم که مطابق تجربه، بهویژه در حوزه هوش مصنوعی جوابی از آنها گرفته نشده است. پیشنهادم این است که تدوین سند در زمینه اخلاق هوش مصنوعی، بهصورت پویا صورت گیرد. یعنی دفعی و یکباره نباشد و سطوح مختلفی داشته باشد. بهگونهای که همراه با بلوغ فناوری و بلوغ دیجیتال در سطح جامعه و بلوغ در سطح عرضه فناوری، بتوانیم اسناد را بهروزآوری کنیم. در این مسیر بهتر است در گام اول، با روش سلبی، رشتههایی مثل فقه و حقوقآزادی در محصولات ، برای تعیین سطح پایه که یک سطح توصیهای است، ورود کنند و خطوط قرمز را تعیین کنند تا فعالان این حوزه پای خود را از آنها فراتر نگذارند. در مراحل بعدی که همراه با پیشرفت فناوری است، نیاز داریم که الگوواره حاکم بر تدوین سند اخلاقی هوش مصنوعی را به «تفسیر» تغییر دهیم. به این معنا که چگونگی پیاده شدن خطوط قرمز در مرحله اول را رصد و تحلیل کنیم. کمکم میتوانیم با پیداکردن یک رویکرد تفسیری، درمورد آنچه که در هوش مصنوعی در کشور پیاده شده، موضع انتقادی بگیریم. و نهایتاً وقتی به این توانمندی میرسیم که نقد بومی و درونگفتمانی نسبت به خودمان و دیگران داشته باشیم، میتوانیم نسخههای ایجابی و اثباتیشدن این اسناد را که خود یک بازه زمانی چندین ساله است، داشته باشیم. دلیل شکست بسیاری از اسناد تدوینشده ما این است که از همان ابتدا یا انتقادی به موضوع نگاه کردهاند و یا اینکه کاملاً اثباتی بودهاند. تا زمانی که ما این چرخه تدوین توصیهنامه، چرخش چرخه صنعت، بیرون آمدن محصولات و بازخوردگیری از آنها را نداشته باشیم، نمیتوانیم موضع نقادانه خوبی نسبت به این اسناد داشته باشیم.

گزارش از: فریبا رضایی

زوال اخلاق پژوهش در ایران

آکادمی و جامعه؛ مسالۀ کاربست پژوهش در ایران